شبکهی ملی اطلاعات، از فلسفه تا اقدام

خانه / مقالات تفصیلی / نقش «دانش شناخت» در کنترل انسان

نقش «دانش شناخت» در کنترل انسان

انتشار یافته در فصلنامهی تخصصی آینده، شمارهی ۱۰ (تابستان ۱۳۹۸)، صفحات ۱۴ الی ۱۹

پیشدرآمد

دانش شناخت -که معادل لغوی Cognitive Science است و در زبان فارسی به اشتباه علوم شناختی نام گرفته- دانشی است که به مطالعهی ذهن، فرایندهای ذهنی [۱] و نحوهی اثرگذاری اطلاعات بر ذهن میپردازد. این مهم از معنای لغوی Cognitive نیز قابل استحصال است که ریشه در Cognition دارد و بهمعنای «شناخت فرایندی» است بهگونهای که بتوان هدف مورد مطالعه را تحت تأثیر و کنترل قرار داد. از این رو دانش شناخت با هر دانشی که بتواند در ایجاب هدف فوق ایفای نقش نماید، ارتباط دارد. لذا دانش شناخت از حیث محتوا دارای یک هستهی اصلی و مستقل است اما برای تأمین اطلاعات مورد نیاز آن، بهصورت بین رشتهای عمل مینماید.

جایگاه دانش شناخت در هندسهی تولید قدرت

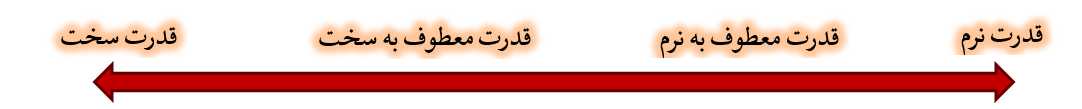

بهطور کل، قدرت[۱] بهمعنای توان تحمیل ارادهی خود بر دیگری است. بر اساس آنکه تحمیل اراده با چه صلابتی صورت پذیرد، چهار حوزهی قدرت سخت، قدرت معطوف به سخت، قدرت معطوف به نرم و قدرت نرم[۲] مطرح میشود.

بنیادیترین نوع قدرت در عصر حاضر، قدرتی است که از حیث صلابت «نرم» باشد. از این رو در منظومهی قدرت، قدرت نرم در کانون قرار میگیرد و سایر قدرتها با آن تنظیم میشوند.

این مهم در متون پایهی علمی و اسناد فرادستی کشورهایی که بهعنوان صاحبان قدرت در عرصهی بینالملل شناخته میشوند، بهصراحت بیان شده است.

از سوی دیگر از منظر جهانبینی لیبرال، مبنای تولید قدرت نرم در عصر حاضر دانش سایبرنتیک[۳] است. لذا سایر دانشهای مولد قدرت در نسبت با سایبرنتیک تنظیم میشوند.

دانش سایبرنتیک

واژهی سایبرنتیک، هم از حیث لغوی و هم از منظر مفاهیم علمی، نه فقط در زبان فارسی بلکه -طبق تحقیقات- در بیشتر زبانهای زندهی امروزی آنطور که واقعاً هست؛ شناخته نشده.

الف) تعریف، هدف و کارکرد دانش سایبرنتیک

بهطور کل سایبرنتیک، دانش کنترل یک پدیدهی هوشمند از طریق جهت دادن به اطلاعاتی است که بهعنوان مبنای تحلیل و نتیجهگیری آن پدیده مورد استفاده قرار میگیرد؛ بهگونهای که در نهایت رفتار آن را طبق خواست کنترلکننده تغییر میدهد. حال اگر پدیدهی مفروض «انسان» باشد کنترل وی منتج به تولید قدرت نرم میشود و اگر آن پدیده «ماشین هوشمند» باشد، از آنجا که هر ماشین از سیستم فرماندهی – کنترل[۴] دستور میگیرد، در نتیجه کنترل آن قدرت فرماندهی – کنترل را رقم میزند. بهعبارت دیگر دانش سایبرنتیک، مبنا و خاستگاه دو قدرتی است که ساز و کار کنترل جهان امروز هستند و تقابل کشورها با یکدیگر از جنبهی این دو قدرت، بهترتیب به جنگ نرم و جنگ فرماندهی – کنترل منتج میشود [۲].

ب) مفهومشناسی و واژهشناسی Cybernetic

کارکرد فوق نه تنها از بستر محتوایی دانش سایبرنتیک بهدست میآید، بلکه حتی از معنای لغوی این واژه نیز مستفاد میشود. Cybernetic ریشه در زبان یونانی دارد و به واژهی kybernetes باز میگردد [۳]. معنای این واژهی یونانی معادل «راهنما»، «فرماندار» و از همه مهمتر «حکومت» میباشد [۴]. در سال ۱۸۳۰ میلادی از ریشهی یونانی آن در زبان فرانسه واژهی «cybernétique» ایجاد شد که تعریف آن «The art of Governor» به معنای «هنر حکومتداری» است [۵]. در سال ۱۸۳۴ نیز فیزیکدان معروف فرانسوی «آندره آمپر»[۵]، این واژه را در طبقهبندی علوم بهمعنای «حکومت و شعبهای از علم سیاست» استعمال نمود [۶]. نهایتاً در سال ۱۹۴۸، نوربرت وینر[۶] برای اولین بار در زبان انگلیسی در کتابی با عنوان «سایبرنتیک: یا کنترل و ارتباط در حیوان و ماشین»[۷] واژهی Cybernetic را بهکار برد. وی در تعریف این واژه گفته است: «تصمیم ما بر این است که کلیات مطالعات نظری کنترل و ارتباطات در ماشین و موجودات زنده را سایبرنتیک بنامیم.»

نسبتشناسی دانش شناخت و سایبرنتیک در حوزهی تولید قدرت

آنچه در خصوص دانش شناخت بسیار مهم است اما مورد غفلت واقع شده، کارکرد آن در حوزهی تولید قدرت است. شاید برای فهم این منظور روشهایی نظیر مطالعات استقرایی، مطالعات معکوس، برآیندگیری از نظرات متخصصان این دانش و سایر روشهای مرسوم مناسب باشد اما دقیقترین و جامعترین شیوه برای فهم نقش دانش شناخت در تولید قدرت، یافتن نسبت آن با دانش سایبرنتیک بهعنوان مبنای تولید قدرت است.

بیان شد که سایبرنتیک، یک پدیدهی هوشمند را از طریق کنترل اطلاعات دریافتی، بهگونهای کنترل مینماید که رفتار آن مطابق خواست کنترلکننده تنظیم شود. بر این اساس دو سؤال مهم مطرح میشود:

- هر پدیدهی هوشمند -اعم از انسان و ماشین- از چه منابعی و چگونه اطلاعات مورد نیاز خود را در امر تصمیمگیری دریافت میکند؟

- هر پدیدهی هوشمند، اطلاعات دریافتی را چگونه تحلیل میکند تا نهایتاً بر اساس آن به تصمیم مقتضی دست یابد؟

پاسخ به دو سؤال فوق مهمترین بخش در ساز و کار قدرت نرم است زیرا عدم شناخت نحوهی دریافت و پردازش اطلاعات سیستم هدف، به شکست کنترل آن توسط قدرت نرم منجر میشود. ضمناً باید توجه داشت چنین نیست که یک پدیدهی هوشمند، همواره بر مبنای یک روش ثابت به کسب اطلاعات و تحلیل آنها بپردازد بلکه ممکن است روشهای آن در نسلهای مختلف تغییر یابد. کما اینکه این نکته دربارهی انسان و ماشینهای هوشمند اثبات شده است.

از سوی دیگر پاسخ به پرسشهای فوق در حوزهی دانش سایبرنتیک تعریف نشده، لذا نیاز است دانشی مستقل اما هماهنگ و یکپارچه با منطق سایبرنتیک، بهطور دائم و مستمر بر روشهای کسب و تحلیل اطلاعات پدیدههای هوشمند مطالعه نماید تا نهایتاً بهواسطهی نتایج آن بتوان از طریق دانش سایبرنتیک به کنترل رفتار آن پدیدهها دست یافت.

این نیاز بسیار مهم و بیبدیل توسط دانش شناخت تأمین میشود. از این رو در نسبتشناسی دانش شناخت و سایبرنتیک میتوان گفت:

دانش سایبرنتیک، مبنای طرحریزی و تولید قدرت نرم برای کنترل پدیدههای هوشمند است و دانش شناخت تبیینگر روشهای اثرگذاری قدرت تولید شده توسط سایبرنتیک بر پدیدههای میباشد.

بنابر این دانش شناخت در مدل جدید قدرت نرم، نقش اسب تروا را ایفا میکند زیرا بهدنبال یافتن راههایی در اهداف است که از طریق آنها بتوان توان تحمیل اراده بر مبنای قدرت نرم را به ثمر رساند.

بر اساس آنچه بیان شد، یک نتیجهی بسیار مهم حاصل میشود که در متون علمی فارسی و انگلیسی پیرامون دانش شناخت به آن اشاره نشده است. بهدلیل آنکه دانش سایبرنتیک بر ماشینهای هوشمند نیز تمرکز دارد تا قدرت فرماندهی – کنترل را بر آنها تحمیل نماید، لازم است دانش شناخت بر روشهای کسب و تحلیل اطلاعات سیستمهای هوشمند نیز مطالعه داشته باشد. این در حالی است که عموم متخصصان تصور میکنند دانش شناخت صرفاً بر ذهن و ادراک انسان تمرکز نموده.

بههمین دلیل است که هوش مصنوعی[۸] و سایر دانشهای مرتبط با ماشینهای هوشمند، نقش و جایگاه کاربردی در دانش شناخت دارند.

سرانجام

شرایط عصر حاضر بهگونهای است که دستیابی به دانش طرحریزی و تولید قدرت نرم را برای تمامی کشورهای جهان ضروری ساخته و ایران اسلامی نیز همانند سایر قدرتهای بینالمللی نیازمند این مهم است. اما باید در نظر داشت تمام آنچه بیان شد ابتناء بر جهانبینی غیر توحیدی لیبرالیسم دارد و مطلقاً نمیتوان از مبانی و روشهای آن در تولید قدرت نرم توحیدی استفاده نمود. اما مطالعه و بررسی دانش شناخت و سایبرنتیک، اولاً در فهم جهانبینی و اندیشهی دشمن در حوزهی قدرت نرم نقشی بیبدیل دارد و ثانیاً مواضع وقوع مفسده در طرحریزی قدرت نرم را برای جهانبینی توحیدی مشخص مینماید. بهعبارت دیگر آنچه مبنای عمل در مدل لیبرالی از قدرت نرم است، بهعنوان نهی و نفی در مدل توحیدی کاربرد دارد.

باید توجه داشت که هرگونه پیروی از مدل قدرت نرم بر مبنای جهانبینی لیبرال، باعث سوق یافتن حکومت و جامعه بهسمت مبانی اندیشهی لیبرالیسم میشود.

لذا تلاش مؤمنین متخصص بر تبیین و تدوین معادلهای توحیدی برای دانش شناخت و سایبرنتیک معطوف شده که به لطف خداوند در این راه نتایج علمی و عملی قابل قبول حاصل گشته است.

ورود به صفحهی اختصاصی مقاله در کتابخانهی سایت، جهت دریافت متن آن با فرمت PDF

منابع

[۱] Stanford Encyclopedia of Philosophy (2019), Cognitive Science, From:

[۲] شکوهیانراد، محمد علی؛ نظریهی جنگ در عصر سیستمهای فرماندهی – کنترل، تهران، ۱۳۹۷، انتشارات شهید سپهبد صیاد شیرازی، ص ۵۹

[۳] Online Etymology Dictionary (2019), Cybernetics, From:

https://www.etymonline.com/word/cybernetics

[۴] Merriam-Webster (2019), Cybernetics, From:

https://www.merriam-webster.com/dictionary/cybernetics

[۵] Wiktionary (2019), ), Cybernetics, From:

https://en.wiktionary.org/wiki/cybernetics

[۶] معتمدنژاد، کاظم؛ وسایل ارتباط جمعی، تهران، ۱۳۸۶، انتشارات دانشگاه علامه طباطبایی، چاپ ششم، ص۴۲-۴۱

[۱] Power

[۲] در نوعی دیگر از دستهبندی، قدرت از حیث صلابت به سه دستهی سخت، نیمهسخت و نرم تقسیم میشود اما امکان تعریف بعضی از مصادیق قدرت را ندارد.

[۳] Cybernetics